Quando desenvolvemos páginas de internet, anúncios emails ou até mesmo folhetos ou cartazes podemos ser levados a pensar que temos a perfeita consciência e os conhecimentos necessários para escolher as melhores imagens, os melhores destaques e os melhores textos para colocar nesses mesmos materiais.

Decidir textos e imagens com base apenas nesse conhecimento pode ser no entanto um erro, que só aumenta de magnitude em suportes digitais, dada a facilidade e disponibilidade que existe hoje para fazer esses testes nos suportes digitais.

Uma imagem, uma expressão ou mesmo uma frase poderá ter impactos totalmente inesperados na sua taxa de conversão. A maioria dos marketeers mais experientes baseia as suas decisões em testes AB, ou em implementações e algoritmos mais complexos que um teste AB, mas que ainda assim partilham o princípio básico do teste AB (testar e validar uma hipótese antes de decidir).

Um teste A/B (por vezes referido como teste 50/50) significa basicamente mostrar aleatoriamente a 50% das pessoas uma versão (A) e a outros 50% uma outra versão (B).

NOTA: Não é necessário que de facto as versões A e B apareçam de forma perfeitamente sequencial, ou seja, dois visitantes seguidos poderão ver apenas uma versão, e poderá no fim ter 522 visitas da versão A e 510 visitas da versão B. Também se poderá fazer que a probabilidade de ver a versão B seja inferior a 50%, de forma a que os testes não possam impactar de forma significativa os seus resultados, caso decida fazer testes mais arrojados.

O aspecto que o Google, a Amazon e o Facebook têm, foram e são desenvolvidos com bases em testes AB. Diz-se que Marissa Meyer quando era responsável da pesquisa do Google, testou 40 tipos de azuis em 2.5% dos visitantes do Google para descobrir qual seria o tom de azul a utilizar nos links que surgem na página de pesquisa do Google, ignorando completamente todos os tons de azul sugeridos e preferidos pela restante equipa e tomando a decisão meramente com base em resultados.

Existem várias questões que deverá ter em atenção se desejar fazer um teste AB, um dos erros mais comuns que acontece quando se decide fazer um teste AB é não determinar o que se pretende exactamente testar com esse teste e deixar-se levar pela vontade de alterar diversas variáveis na versão B e posteriormente tirar conclusões erradas sobre o que testou e sobre o que venceu ou perdeu nesse teste.

Suponhamos que tem o seguinte imagem e texto (versão A) numa página de internet ou mesmo num anúncio:

(imagem de uma pessoa sorridente)

Seguro de Saúde para a sua Família

Proteja quem é mais importante

e decide testar a versão B:

(imagem de uma família sorridente) <- alterado

Seguro de Saúde para a sua Família

Por apenas 24.99€ por mês <- alterado

Supondo que a versão B tem uma melhor taxa de conversão e significância estatística, o que podemos concluir é que a imagem de uma família sorridente e destacar o preço do seguro no texto, aumenta a taxa de conversão, correcto?

Sim e não, ou seja, sim, as duas alterações em conjunto de facto melhoraram a taxa de conversão da página, no entanto não podemos concluir com certeza que ambas as alterações individualmente impactam positivamente a taxa de conversão.

Porque poderíamos afirmar que umas das seguintes versões poderia ter até uma melhor taxa de conversão que a versão B e simultaneamente uma poderia ter uma pior taxa de conversão que a versão A:

Versão C

(imagem de uma família sorridente) <- alterado

Seguro de Saúde para a sua Família

Proteja quem é mais importante

Versão D

(imagem de uma pessoa sorridente)

Seguro de Saúde para a sua Família

Por apenas 24.99€ por mês <- alterado

Se ambas as versões (C e D) tivessem de facto uma melhor taxa de conversão que a versão A, poderíamos inferir que a versão B seria de facto a melhor versão das 4 versão, mas caso isso não acontecesse, isso significava que o ganho que uma alteração fez positivamente na taxa de conversa, a outra alteração afectou negativamente (por exemplo: o texto melhorou a taxa de conversão, a nova imagem piorou, ambas as alterações melhoram a taxa de conversão mas alterar apenas o texto melhoria ainda mais a taxa de conversão).

A vantagem de alterar apenas uma variável quando corre um teste AB é que pode aprender de facto identificar e isolar o que aumentou a sua taxa de conversão e desta forma optimizar gradualmente a sua conversão, e sempre daforma mais eficiente possível.

A desvantagem é que de facto, quando existem muitas alterações a fazer e muitas possibilidades a testar, esta abordagem poderá ser bastante mais cansativa. De qualquer forma deve sempre ter a noção que quando se faz uma versão alterando várias variáveis, não pode depois concluir que todas as variáveis que alterou e testou são de facto melhores que as anteriores.

Significância Estatística

Uma pergunta frequente quando se corre testes AB é: “quantas visitas preciso de ter para terminar um teste AB?”.

A resposta correcta é que depende de duas coisas. Primeiramente depende do nível de confiança que pretende ter (por norma 95% é o que é utilizado na maioria dos testes científicos, mas poderá reduzir para 80% se tiver pressa em tomar decisões) e segundamente depende da taxa de conversão e o tamanho das amostras quer dos visitantes da versão A quer da versão B.

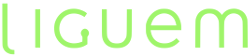

Supondo que existem 2 testes A/B a correr:

A1) 100 visitas, 2 conversões – 2% de taxa de conversão

B1) 100 visitas, 3 conversões – 3% de taxa de conversão

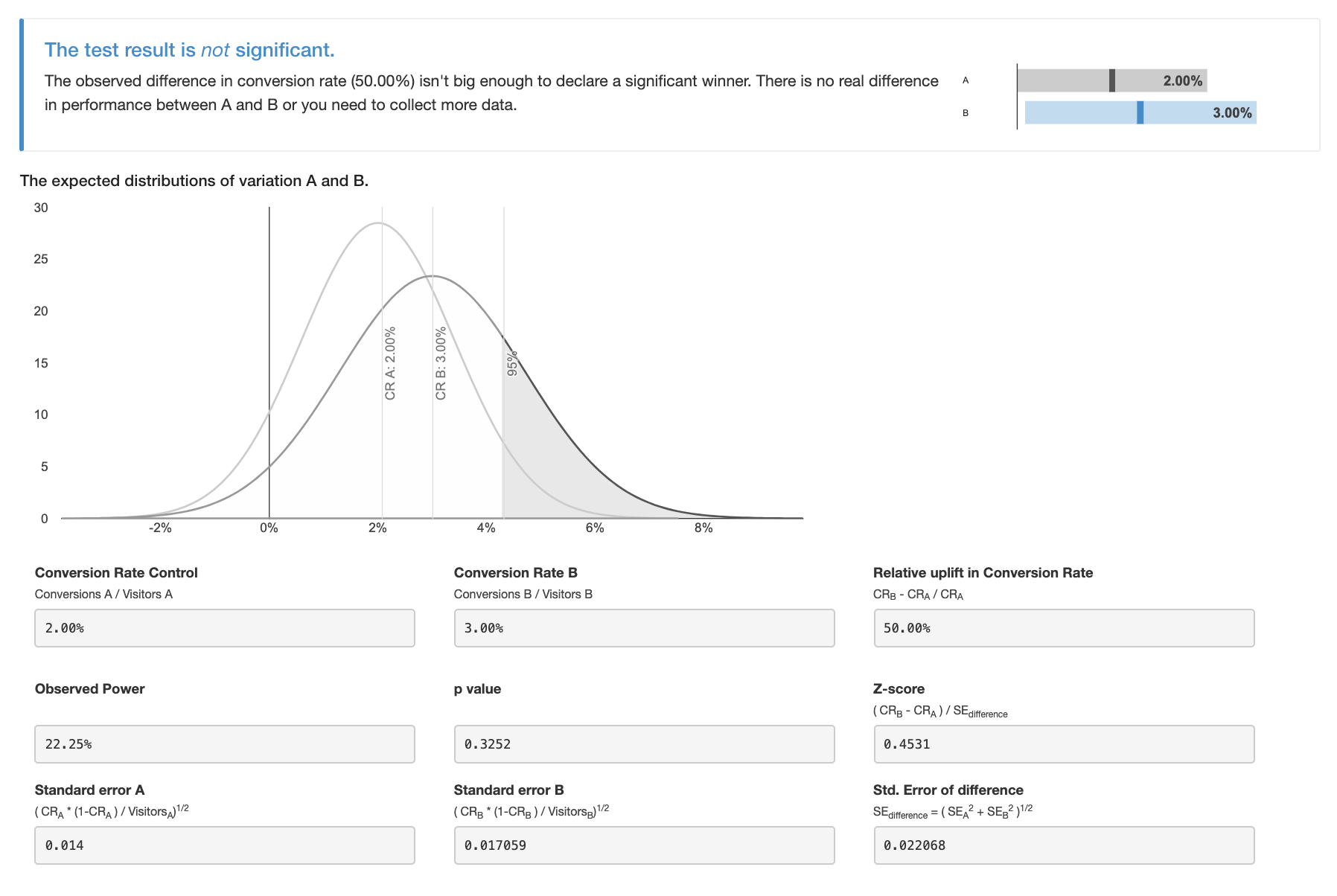

A2) 10000 visitas, 200 conversões – 2% de taxa de conversão

B2) 10000 visitas, 300 conversões – 3% de taxa de conversão

Aparentemente poderemos tirar as mesmas conclusões de ambos os testes, dado que as taxas de conversão são idênticas?

Se considerarmos a confiança estatística, a resposta é que não podemos, a significância estatística do primeiro teste, apesar da diferença de +50% na taxa de conversão, é baixa, ou seja ainda existe um factor aleatório que não permite concluir que de facto existe uma diferença significativa na taxa de conversão da versão B versus a versão A.

Já se considerarmos o segundo teste AB, apesar da mesma diferença na taxa de conversão, já existe significância estatística para concluir que a versão B é de facto melhor que a versão A.

Poderá usar diversas ferramentas online para facilmente calcular a significância estatística do seu teste AB, ajudando-o assim a responder se pode dar como terminado um teste AB. Recomendamos esta calculadora

Na liguem utilizamos testes AB para melhor a Lead Generation para os nossos clientes, esperamos que possamos ter esclarecido um pouco mais acerca dos testes AB e que os possa usar na sua empresa, recordando que este teste não se aplica apenas a materiais digitais. Empresas já o fizeram com folhetos, outdoors e até anúncios televisivos (utilizando dois números de telefone ou dois endereços de internet para medir resultados da versão A e B).

Tenha atenção que existe um grande risco nos testes AB, quando se começa a realizar testes AB nas suas páginas ou anúncios, os ganhos incrementais dos seus resultados. Consuma-os com ou sem moderação.